Meta刚刚推出了一种新的AI训练方法,可能会改善机器处理信息和响应查询的方式。这种被称为思维偏好优化(TPO)的技术教会语言模型在给出答案之前进行内部思考。换句话说:它们在思考,某种程度上。

TPO基本上就像给AI一个心理暂停按钮,让它在给出第一反应之前先考虑一下。结果是?更尖锐、更细致的回复,听起来不再像机器人,而更像一个深思熟虑的人类。

这意味着,TPO可能使Meta更接近于提供一个开源替代品,以取代像OpenAI的草莓(又名o1)这样的专有模型,以其复杂的问题解决能力而闻名。

Meta的方法与传统的“思维链”提示方法不同,后者迫使AI通过不同的迭代展示其工作过程。TPO则将心理体操隐藏起来,模型在一次性完成所有工作。

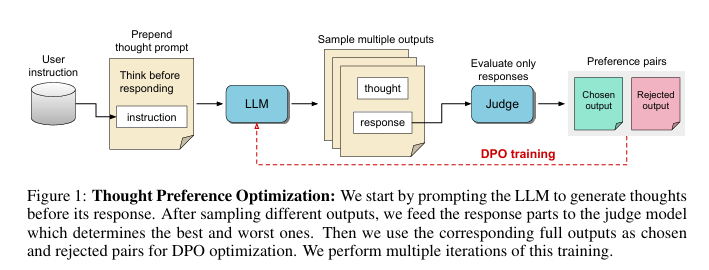

训练过程也不同于简单地告诉模型“逐步思考”。研究人员从一个基本的指令遵循模型开始,提示它在回答之前生成内部思考。通过迭代强化学习,AI磨练其思维技能,由一个只评估最终输出的评判模型引导——这就是用户所看到的内容。

图片:Meta

这种不干预的方法使AI能够发展出自己独特的思维模式,可能导致更具创造性和适应性的问题解决。这是朝着AI不仅仅遵循规则,而是实际理解其背后推理的一步。

Meta的创新受到认知科学的启发,模仿人类在处理复杂问题之前暂停和反思的倾向。如果AI模型学会为更困难的任务分配更多的“计算时间”,那么下一代开源模型可能会大幅超越我们目前使用的模型。

最棒的是,Meta的TPO技术不需要大量的新数据来发挥其魔力。它基于现有的AI架构,调整它们以模拟思维过程,而无需人类的指导。这可能加速更智能的AI助手、聊天机器人和其他基于语言的工具的发展,使它们在问题解决的方式上更具创造性。

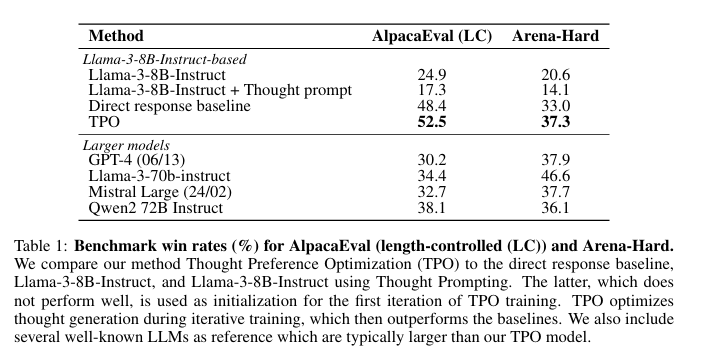

Meta的研究人员将他们的方法与行业标准基准进行了测试。经过TPO训练的模型展现了其新获得的认知能力,在复杂任务上超越了那些不进行思考的模型。

图片:Meta

更接近开源草莓?

Meta在使AI更智能的领域取得了有趣的进展。就在三个月前,其研究人员介绍了“系统2蒸馏”,这是一种教会大型语言模型(LLMs)如何解决复杂任务而不输出不必要步骤的技术。

系统2蒸馏受到人类认知过程的启发,教会LLMs在不需要逐步提示的情况下执行复杂任务——这通常被认为是高级提示工程的首选方法。通过对经过验证的系统2提示技术的响应进行微调,研究人员表明,AI可以内化复杂的推理技能,通常能够匹配或超越显式推理方法的表现。

系统1思维是快速、直观和自动的。这是我们用于快速判断、模式识别和熟悉任务的心理过程。在AI术语中,这与大型语言模型的典型操作方式相一致——快速生成基于学习模式的响应。

相比之下,系统2思维是缓慢、深思熟虑和分析性的。这是人类在复杂问题解决、逻辑推理和规划时所进行的处理类型。AI研究人员一直在努力通过各种提示技术在语言模型中复制这一过程,迫使AI展示其工作或逐步推理。

Meta的思维偏好优化和与系统2蒸馏相关的研究代表了在AI中桥接这两种思维模式的尝试。目标是赋予AI模型进行深度系统2风格推理的能力,而不牺牲系统1处理的速度和效率。

这种方法涉及训练AI内化复杂的推理过程。通过这样做,模型可以更有效地处理复杂问题,模仿人类在获得任务专业知识时从有意识、费力的思维转向更自动化的处理。

时机恰到好处,因为Meta的研究恰逢开源AI领域动荡的一个月。备受期待的Reflection 70B模型,被誉为推理强者,结果却是烟雾和镜子。原本承诺的嵌入式思维链模型在OpenAI发布o1之前,最终却成为一个无法兑现承诺的模型,一些用户甚至指责创作者只是对Anthropic的Claude进行了包装。

现在,其开发者在不同的公开事后分析中互相指责,让AI社区感到震惊。这个想法的提出者Matt Schumer目前正在用自己的硬件和数据集训练一个新版本。

如果Meta的方法证明成功,那么它可能为OpenAI的o1模型铺平道路,成为一个开源竞争对手。一个开源替代品可以使这种先进的AI思维的获取变得更加民主化。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。