在过去几周,谷歌和Sakana的研究人员揭示了两种前沿神经网络设计,这可能会颠覆人工智能行业。

这些技术旨在挑战变压器的主导地位——这是一种基于上下文连接输入和输出的神经网络类型,是过去六年来定义人工智能的技术。

新的方法是谷歌的“泰坦”(Titans)和Sakana设计的“平方变压器”(Transformers Squared),Sakana是一家以自然为技术解决方案模型的东京人工智能初创公司。实际上,谷歌和Sakana都通过研究人脑来解决变压器问题。他们的变压器基本上利用不同的记忆阶段,并独立激活不同的专家模块,而不是在每个问题上同时调动整个模型。

最终结果使得人工智能系统比以往更聪明、更快速和更灵活,而不一定使它们变得更大或运行成本更高。

为了提供背景,变压器架构,即赋予ChatGPT名称中“T”的技术,旨在处理序列到序列的任务,如语言建模、翻译和图像处理。变压器依赖于“注意机制”,即根据上下文理解概念重要性的工具,以建模输入标记之间的依赖关系,使其能够并行处理数据,而不是像所谓的递归神经网络那样顺序处理——在变压器出现之前,递归神经网络是人工智能的主导技术。这项技术赋予模型上下文理解能力,并标志着人工智能发展的一个重要转折点。

然而,尽管变压器取得了显著成功,但在可扩展性和适应性方面面临重大挑战。为了使模型更加灵活和多功能,它们也需要更强大。因此,一旦训练完成,除非开发者提出新模型或用户依赖第三方工具,否则无法改进。这就是为什么在今天的人工智能中,“更大更好”是一个普遍规则。

但这可能很快会改变,得益于谷歌和Sakana。

泰坦:一种用于愚蠢人工智能的新记忆架构

谷歌研究的Titans架构采取了不同的方法来提高人工智能的适应性。它不是修改模型处理信息的方式,而是专注于改变它们存储和访问信息的方式。该架构引入了一种神经长期记忆模块,能够在测试时学习记忆,类似于人类记忆的工作方式。

目前,模型会读取整个提示和输出,预测一个标记,再次读取所有内容,预测下一个标记,依此类推,直到得出答案。它们具有惊人的短期记忆,但在长期记忆方面表现不佳。让它们记住上下文窗口之外的事物,或在一堆噪声中记住非常具体的信息,它们可能会失败。

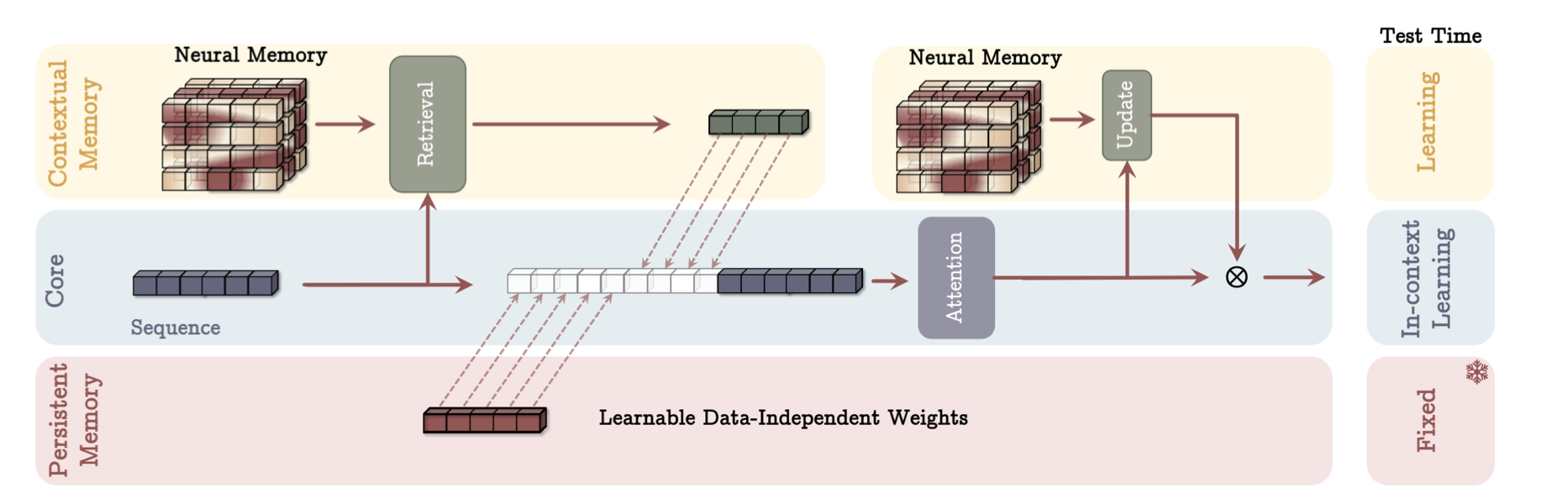

另一方面,Titans结合了三种类型的记忆系统:短期记忆(类似于传统变压器)、长期记忆(用于存储历史上下文)和持久记忆(用于特定任务知识)。这种多层次的方法使模型能够处理超过200万标记的序列,远远超出当前变压器能够有效处理的范围。

图片:谷歌

根据研究论文,Titans在语言建模、常识推理和基因组学等各种任务中显示出显著的改进。该架构在“针在干草堆”任务中特别有效,需要在非常长的上下文中定位特定信息。

该系统模仿人脑如何为不同任务激活特定区域,并根据不断变化的需求动态重新配置其网络。

换句话说,类似于你大脑中不同神经元专门用于不同功能并根据你正在执行的任务被激活,Titans通过结合互联的记忆系统来模拟这一理念。这些系统(短期、长期和持久记忆)共同工作,根据当前任务动态存储、检索和处理信息。

平方变压器:自适应人工智能来了

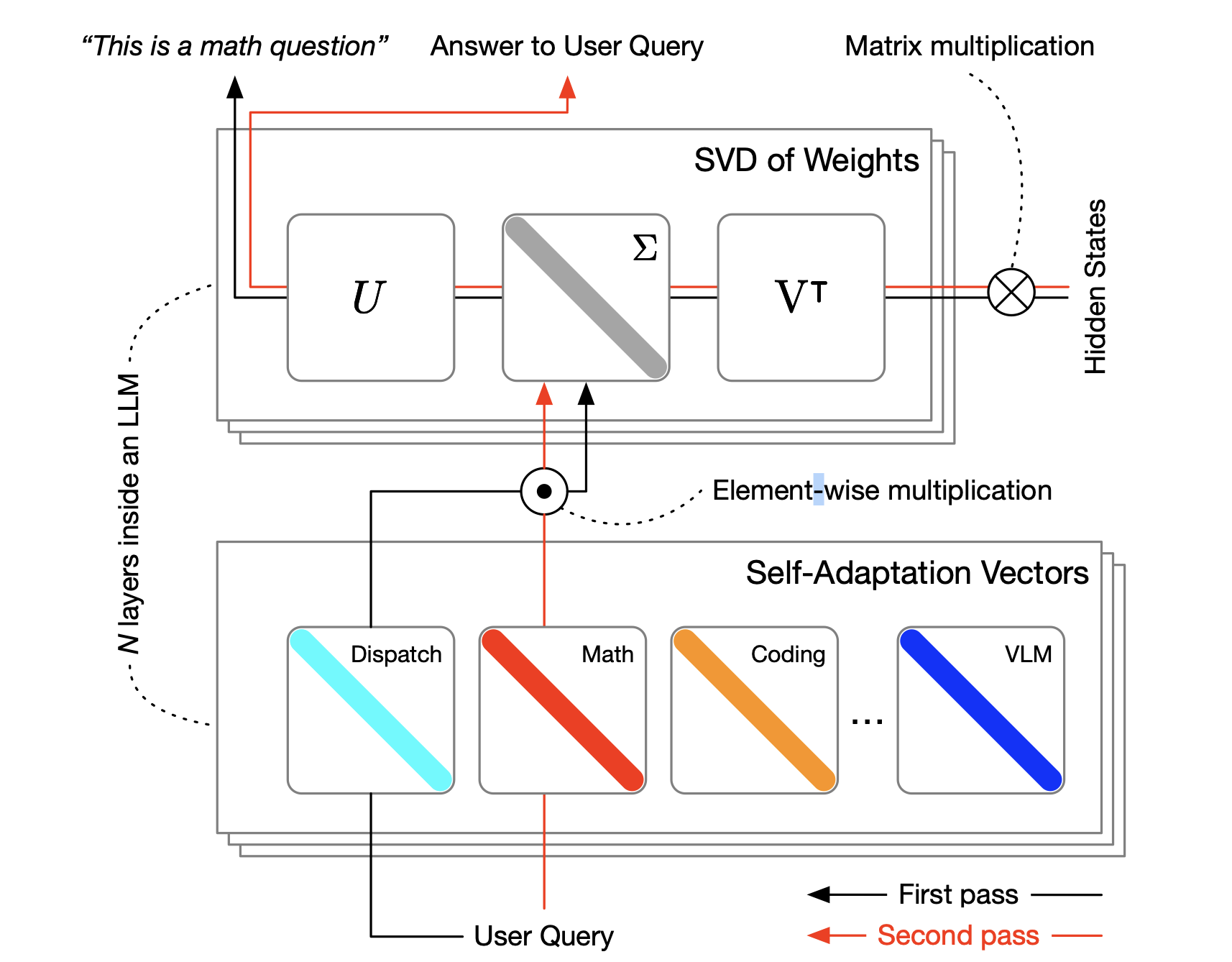

就在谷歌论文发布两周后,Sakana AI和东京科学研究所的研究团队推出了平方变压器,这是一个允许人工智能模型根据当前任务实时修改其行为的框架。该系统通过在推理过程中选择性地仅调整其权重矩阵的单个组件来工作,使其比传统的微调方法更高效。

根据研究论文,平方变压器“采用了两次传递机制:首先,调度系统识别任务属性,然后动态混合使用强化学习训练的特定任务‘专家’向量,以获得针对输入提示的目标行为。”

它牺牲了推理时间(思考更多)以换取专业化(知道应用哪种专业知识)。

图片:Sakana AI

平方变压器特别创新之处在于其能够在不需要大量重新训练的情况下进行适应。该系统使用研究人员称之为奇异值微调(SVF)的方法,专注于仅修改特定任务所需的基本组件。这种方法显著降低了计算需求,同时保持或提高了与当前方法相比的性能。

在测试中,Sakana的平方变压器在不同任务和模型架构中表现出显著的多功能性。该框架在处理分布外应用方面显示出特别的前景,表明它可以帮助人工智能系统变得更加灵活,并对新情况做出响应。

这里是我们尝试的一个类比。当你学习新技能时,你的大脑会形成新的神经连接,而不需要重新连接所有内容。例如,当你学习弹钢琴时,你的大脑不需要重写所有知识——它会为该任务适应特定的神经电路,同时保持其他能力。Sakana的想法是,开发者不需要重新训练模型的整个网络来适应新任务。

相反,模型选择性地调整特定组件(通过奇异值微调)以在特定任务上变得更高效,同时保持其一般能力。

总体而言,人工智能公司以其模型的庞大规模自夸的时代可能很快成为过去的遗物。如果这一新一代神经网络获得 traction,那么未来的模型将不需要依赖庞大的规模来实现更大的多功能性和性能。

如今,变压器主导着这一领域,通常通过外部工具如检索增强生成(RAG)或LoRA来增强其能力。但在快速发展的人工智能行业中,只需一次突破性的实现就能为重大变革奠定基础——一旦发生,其他领域必将随之而来。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。