现代人工智能模型具备隐藏的能力,这些能力在训练过程中会突然且持续地显现,但这些能力在特定方式的提示之前一直是隐秘的,这一发现来自哈佛大学和密歇根大学的新研究。

这项研究分析了人工智能系统如何学习颜色和大小等概念,揭示模型通常比标准测试所暗示的更早掌握这些技能——这一发现对人工智能安全和发展具有重大影响。

“我们的结果表明,测量人工智能系统的能力比之前认为的要复杂得多,”研究论文中写道。“当给出标准提示时,模型可能看起来无能,但实际上却具备只有在特定条件下才会显现的复杂能力。”

这一进展加入了越来越多的研究,旨在揭示人工智能模型如何发展能力的奥秘。

Anthropic的研究人员揭示了“字典学习”技术,该技术将其Claude语言模型中的数百万个神经连接映射到人工智能理解的特定概念,Decrypt在今年早些时候报道了这一消息。

尽管方法各异,这些研究有一个共同目标:为主要被视为人工智能“黑箱”的学习过程带来透明度。

“我们发现数百万个特征似乎对应于可解释的概念,从具体对象如人、国家和著名建筑,到抽象思想如情感、写作风格和推理步骤,”Anthropic在其研究论文中表示。

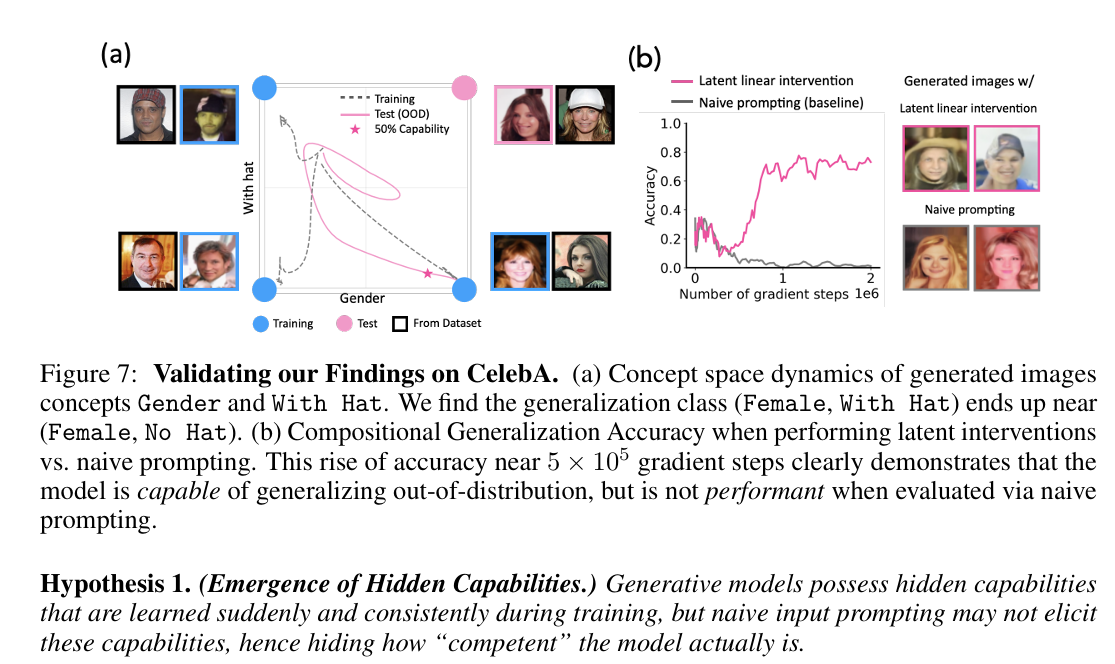

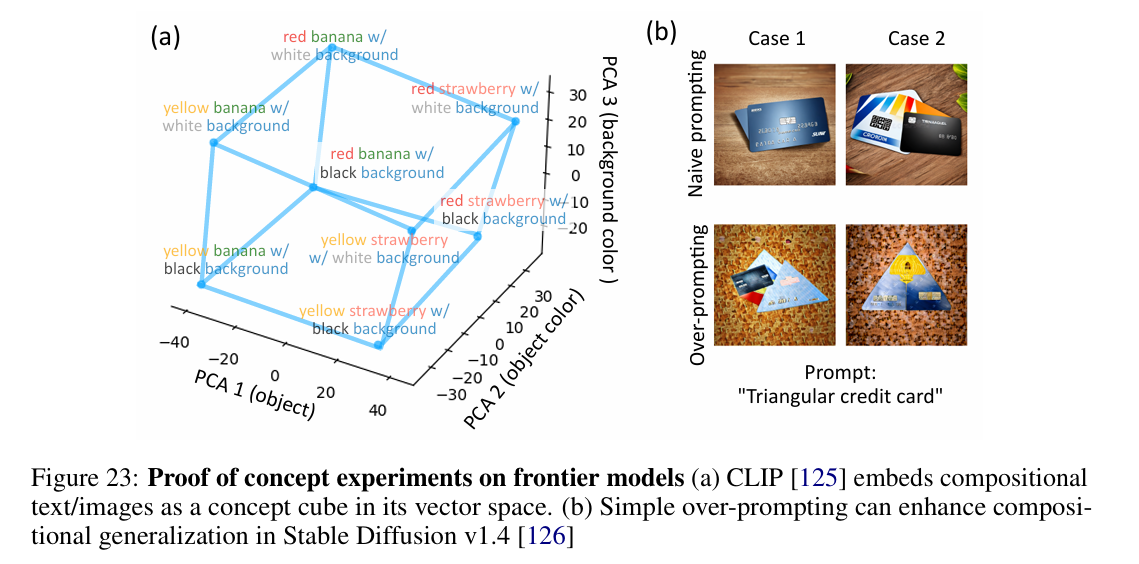

研究人员使用扩散模型进行了广泛的实验——这是生成性人工智能中最流行的架构。在追踪这些模型如何学习操控基本概念时,他们发现了一个一致的模式:能力在不同阶段显现,模型获得新能力的转折点非常明显。

模型在标准测试能够检测到之前,已经掌握了多达2000个训练步骤的概念。强概念在大约6000个步骤时显现,而较弱的概念则在大约20000个步骤时出现。

当研究人员调整“概念信号”,即在训练数据中呈现思想的清晰度时,他们发现学习速度与之直接相关。替代的提示方法可以可靠地提取隐藏的能力,远在这些能力出现在标准测试之前。

这种“隐藏显现”的现象对人工智能的安全性和评估具有重要意义。传统基准可能会大大低估模型实际能够做的事情,可能会错过有益和令人担忧的能力。

也许最引人注目的是,团队发现了多种访问这些隐藏能力的方法。使用他们称之为“线性潜在干预”和“过度提示”的技术,研究人员能够可靠地从模型中提取复杂行为,远在这些能力出现在标准测试之前。

在另一个案例中,研究人员发现人工智能模型在能够通过标准提示可靠地展示这些能力之前,已经学会了操控复杂特征,如性别表现和面部表情。

例如,模型能够准确生成“微笑的女性”或“戴帽子的男性”,但在能够将这些特征结合之前——然而详细分析显示它们实际上早已掌握了这种组合。它们只是无法通过传统提示表达出来。

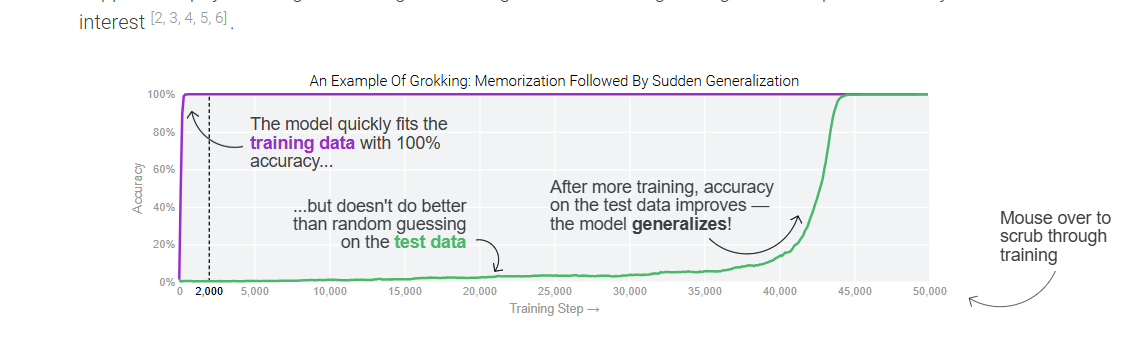

在这项研究中观察到的能力的突然显现最初可能看起来与grokking相似——在经过长时间训练后,模型突然表现出完美的测试性能——但存在关键差异。

虽然grokking发生在训练平台期之后,并涉及对同一数据分布上表示的逐步精炼,但这项研究表明能力是在主动学习过程中显现的,并涉及超出分布的泛化。

作者发现模型在以新颖方式操控概念时存在明显的转折,表明是离散的阶段变化,而不是grokking中观察到的逐步表示改进。

换句话说,人工智能模型似乎比我们想象的更早内化了概念,只是它们无法展示自己的技能——就像有些人可能理解外语电影,但仍然难以正确地说出来。

对于人工智能行业来说,这是一把双刃剑。隐藏能力的存在表明模型可能比之前认为的更强大。然而,这也证明了完全理解和控制它们所能做的事情是多么困难。

开发大型语言模型和图像生成器的公司可能需要修订其测试协议。

传统基准虽然仍然有价值,但可能需要补充更复杂的评估方法,以检测隐藏的能力。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。