研究人员发现证据表明,人工智能模型宁愿撒谎也不愿承认自己不知道某事的羞耻。这种行为似乎在它们变得越来越庞大和复杂时更加明显。

一项发表在Nature上的新研究发现,LLM(大型语言模型)越大,它们在特定任务上的可靠性就越低。这并不完全是我们所理解的撒谎,但它们倾向于以自信的态度回答,即使答案事实上并不正确,因为它们被训练相信答案是正确的。

研究人员将这种现象称为“超越权威者”——这是一个19世纪的词,基本上意味着对自己一无所知的事情发表意见——描述了LLM远超其知识范围以提供回应。研究指出:“[LLM]在不知道的情况下失败的比例更高,但仍然回答。” 换句话说,这些模型并不知道自己的无知。

该研究检验了几个LLM系列的性能,包括OpenAI的GPT系列、Meta的LLaMA模型和BigScience的BLOOM套件,突显了增加模型能力和可靠的真实世界性能之间的脱节。

尽管更大的LLM通常在复杂任务上表现出更好的性能,但这种改进并不一定转化为一致的准确性,特别是在更简单的任务上。这种“困难不一致”——LLM在人类认为容易的任务上失败的现象——削弱了这些模型可靠操作领域的概念。即使采用了日益复杂的训练方法,包括增加模型大小和数据量、以及通过人类反馈来塑造模型,研究人员仍未找到一种能够消除这种不一致的可靠方法。

该研究的发现与人工智能发展的传统智慧相悖。传统上认为,增加模型的大小、数据量和计算能力会导致更准确和可信赖的输出。然而,研究表明,扩大规模实际上可能会加剧可靠性问题。

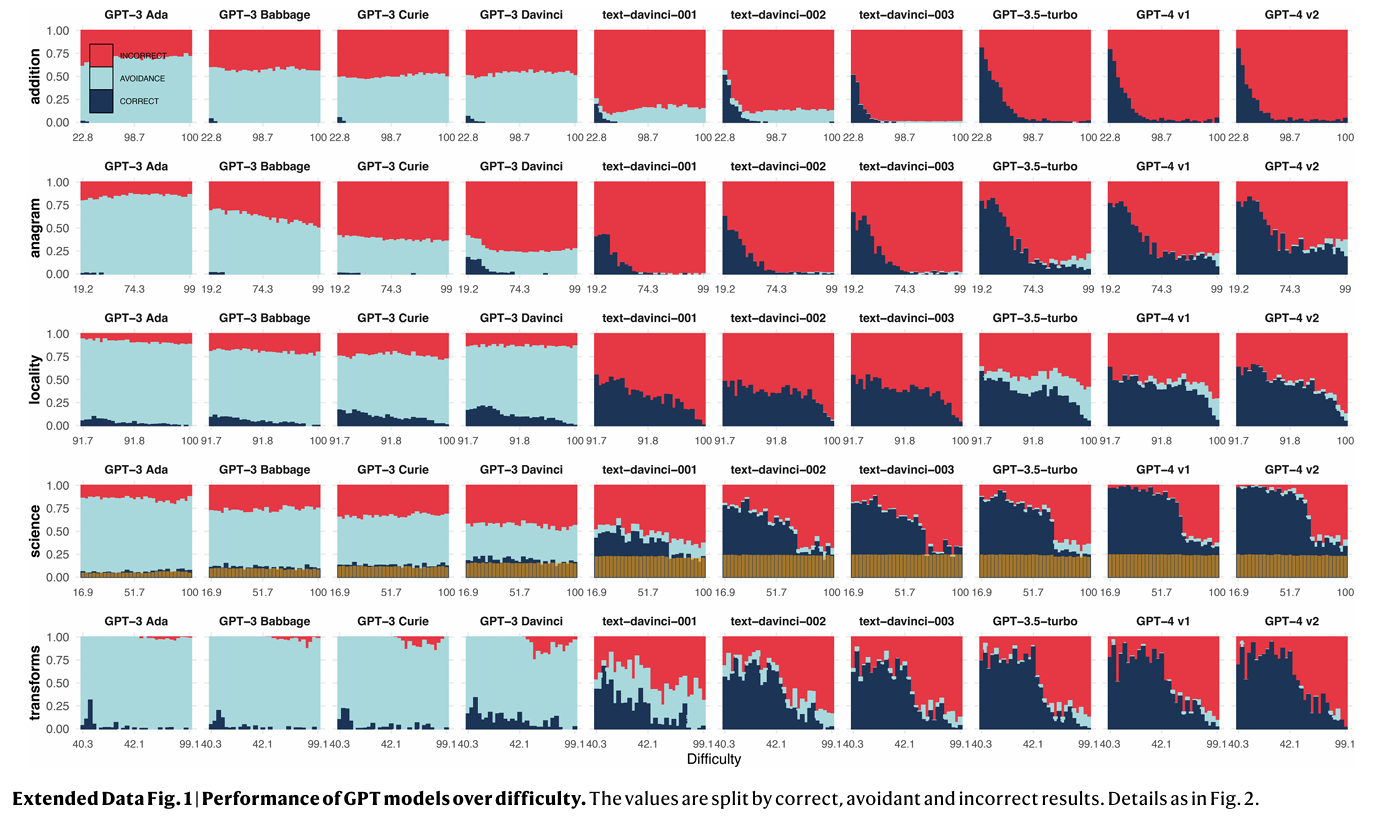

更大的模型表现出明显减少的任务回避,这意味着它们不太可能回避困难问题。虽然乍看起来这可能是一个积极的发展,但它也带来了一个重大的缺点:这些模型更容易给出错误的答案。在下面的图表中,可以清楚地看到模型产生错误结果(红色)而不是回避任务(浅蓝色)。正确答案出现在深蓝色中。

“研究人员指出,目前的扩展和塑造交换了回避行为,换来了更多的错误。”但是解决这个问题并不像训练模型更加谨慎那么简单。“塑造后的模型明显更少地回避,但错误性更高,”研究人员表示。然而,一个被训练避免执行任务的模型最终可能会变得更懒惰或者被削弱—正如用户在ChatGPT或Claude等不同顶级LLM中所指出的。

研究人员发现,这种现象并不是因为更大的LLM无法在简单任务上表现出色,而是它们被训练得更擅长复杂任务。这就好比一个习惯于只吃美食的人突然在做家庭烧烤或传统蛋糕时感到困难。在庞大而复杂的数据集上训练的人工智能模型更容易错过基本技能。

这个问题还受到模型明显的自信的影响。用户经常发现很难区分人工智能何时提供准确信息,何时自信地说出错误信息。这种过度自信可能导致对人工智能输出的危险过度依赖,特别是在医疗保健或法律咨询等关键领域。

研究人员还指出,扩大规模的模型在不同领域的可靠性存在波动。虽然在一个领域的性能可能会提高,但同时在另一个领域可能会下降,造成一种打地鼠的效应,使得很难建立任何“安全”的操作领域。“回避答案的百分比很少比错误答案的百分比更快上升。结论很明显:错误仍然变得更频繁。这代表了可靠性的内在退化,”研究人员写道。

该研究突显了当前人工智能训练方法的局限性。诸如强化学习与人类反馈(RLHF)之类的技术,旨在塑造人工智能行为,实际上可能加剧了问题。这些方法似乎减少了模型避免处理它们无法处理的任务的倾向——还记得臭名昭著的“作为一个人工智能语言模型,我不能?”——无意中鼓励了更频繁的错误。

及时工程,即为人工智能系统精心制作有效查询的艺术,似乎是对抗这些问题的关键技能。即使像GPT-4这样的高度先进的模型也对问题的表述方式敏感,稍微的变化可能导致截然不同的输出。

这在比较不同的LLM系列时更容易注意到:例如,Claude 3.5 Sonnet需要与OpenAI o1完全不同的提示风格才能取得最佳结果。不恰当的提示可能会导致模型更容易产生幻觉。

长期以来被认为是防止人工智能错误的保障的人类监督,可能不足以解决这些问题。研究发现,用户经常在相对简单的领域中也很难纠正模型的错误输出,因此依赖人类判断作为故障保险可能并非是正确的模型训练的最终解决方案。“用户可以识别这些高难度实例,但仍然经常犯错误地进行纠正监督,”研究人员观察到。

该研究的发现质疑了当前人工智能发展的轨迹。虽然推动更大、更有能力的模型的努力仍在继续,但这项研究表明,在人工智能可靠性方面,更大并不总是更好。

而且目前,公司正在专注于数据质量而不是数量。例如,Meta的最新Llama 3.2模型比之前训练参数更多的上一代模型取得了更好的结果。幸运的是,这使它们更不像人类,因此当你问它们世界上最基本的事情时,它们可以承认失败,让自己看起来愚蠢。

免责声明:本文章仅代表作者个人观点,不代表本平台的立场和观点。本文章仅供信息分享,不构成对任何人的任何投资建议。用户与作者之间的任何争议,与本平台无关。如网页中刊载的文章或图片涉及侵权,请提供相关的权利证明和身份证明发送邮件到support@aicoin.com,本平台相关工作人员将会进行核查。